ROI von Produktdatenqualität (Teil 1)

Wir alle leben mitten im Informationszeitalter, das sich vor allem durch die zunehmende Digitalisierung und ein exponentielles Datenwachstum auszeichnet. Darf man einem großen amerikanischen Marktforschungsunternehmen glauben, wächst die erzeugte Datenmenge pro Jahr bis 2020 auf ca. 44 Zettabytes (IDC, 2014). Das ist zehn Mal so viel im Vergleich zu 2013 und entspricht unvorstellbaren 44 Milliarden 1TB-Festplatten. Wir spüren das auch im Alltag, wenn immer mehr Geräte mit Sensoren ausgestattet sind und selbst der Kühlschrank demnächst dann wohl automatisch erkennt, wann er neue Lebensmittel bestellen soll.

Das Mehr an Daten führt nicht nur im privaten Kontext zur Notwendigkeit eines effizienteren Datenmanagements. Auch in Unternehmen ist beispielsweise zunehmend häufiger die Position des CDO (Chief Data Officer) anzutreffen, dessen Hauptaufgaben in der Definition von unternehmensweiten Datenstandards und der Initiierung von Data Governance-Initiativen liegen. Diese Initiativen tragen maßgeblich dazu bei, die Datenflut aus einer zentralen Funktion zu managen und auch besonders sensible Daten vor den Augen allzu neugieriger Blicke zu schützen.

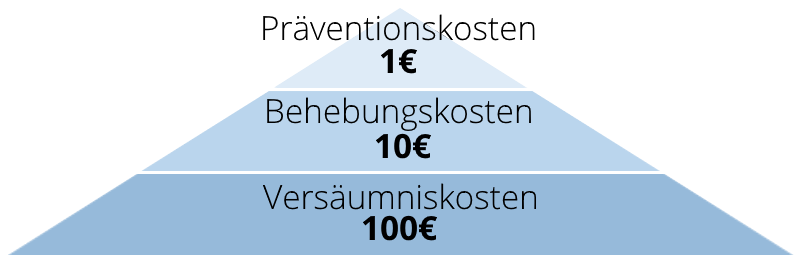

Als Beratungs-Dienstleister sind wir bei parsionate oft in der Rolle Empfehlungen für ein effizientes Datenmanagement zu geben. Hierbei hat sich die 1-10-100-Regel (Chang, 1994) als sinnvolle Methode herausgestellt, um die Auswirkungen von Qualitätsproblemen näherungsweise zu beschreiben. Demnach sind die Kosten am geringsten, wenn mögliche Probleme präventiv, also am besten direkt bei der Dateneingabe eines Benutzers, erkannt werden. Bis zu zehnfach höhere Kosten fallen dagegen an, wenn in einer nachgelagerten Qualitätsprüfung und durch zusätzlichen Aufwand Probleme behoben werden. Am teuersten ist die Behebung eines Datenproblems, wenn sich die Daten bereits im Zielsystem befinden. Stellen Sie sich vor, potenzielle Käufer eines Produkts in Ihrem Webshop bekommen falsche oder irreführende Informationen angezeigt und schicken es deshalb wieder zurück.

Daher gilt: Datenqualität sollte möglichst an der Quelle, wo die Daten entstehen, kontrolliert und Probleme direkt behoben werden. Dies spart Geld und sichert auch allen konsumierenden Systemen dieselbe Qualität der Daten.

Schauen wir uns den Begriff „Datenqualität“ (DQ) etwas genauer an. Eine häufig in der Literatur anzutreffende Definition lautet:

„Daten haben eine hohe Qualität, wenn sie geeignet für ihre beabsichtigte Verwendung sind.“ (Juran, 1951) Der daraus ableitbare Grundsatz der Gebrauchstauglichkeit von Daten beschreibt die generelle Zielrichtung bei der DQ-Verbesserung: nicht die bestmöglich denkbare Qualität ist das Ziel, sondern eine dem jeweiligen Anwendungsfall entsprechende. Beispielsweise ist es wenig hilfreich, für einen Produktdatensatz einen aufwändig formatierten Richtext mit verlinkten Bildern zu pflegen, wenn es kein Zielsystem gibt, das die Formatierung darstellen kann und die enthaltenen Steuerzeichen den Text noch unleserlich machen.

Aber wie kann diese Gebrauchstauglichkeit nun in praktisch anwendbare Kriterien für gute Datenqualität heruntergebrochen werden? Am gebräuchlichsten sind hierfür sogenannte DQ-Dimensionen, die die Datenqualität erst messbar und damit bewertbar machen.

Folgende Dimensionen werden im Allgemeinen verwendet:

Somit genügt es beispielsweise nicht ein Auslaufdatum eines Artikels aus dem ERP-System als Pflichtfeld zu übernehmen, um die Sichtbarkeit im Webshop zu steuern (Vollständigkeit). Es muss ebenso sichergestellt sein, dass dies in einem für den Webshop lesbaren Format übergeben wird (Konformität). Denn ansonsten kann es passieren, dass eventuell die Tages- als Monatsangabe interpretiert wird und somit eine im besten Fall ungültige (Tag > 12) oder sogar falsche Information entsteht (Richtigkeit).

Zusätzlich zu den sechs technischen Dimensionen wird in einem DQ-Projekt auch immer die Prozess-Qualität evaluiert. Diese setzt sich meist aus den organisatorischen Gegebenheiten eines Unternehmens und den damit verbundenen Rollen und Verantwortlichkeiten für die verschiedenen Datendomänen zusammen. Grundsätzlich sollte heutzutage aufgrund der immer komplexer werdenden Datenstrukturen in mittleren bis größeren Unternehmen ein zentrales Data Governance-Gremium etabliert werden, das sich aus Experten verschiedener Fachbereiche zusammensetzt und gemeinschaftlich Datenmodelle, -hoheiten und –Pflegeprozesse diskutiert. Hierbei sollte bedacht werden, dass die wirkungsvolle Etablierung eines solchen Gremiums meistens eine weitaus langfristigere und damit im Vergleich zur reinen Verbesserung technischer DQ-Dimensionen teurere Aufgabe darstellt. Nichtsdestotrotz kann dadurch aber eine nachhaltigere Optimierung der datengetriebenen Prozesse in einem Unternehmen erreicht werden, das ihrer zunehmenden Bedeutung deutlich besser gerecht wird.

Im nächsten Teil der Beitragsreihe soll die generelle Vorgehensweise von parsionate in einem DQ-Projekt vorgestellt werden, die die Voraussetzung für eine Renditeberechnung der Produktdatenqualität darstellt.

>> ROI von Produktdatenqualität – Vorgehen im Projekt

Autor: Christoph Koch und Technical Consultant

Lesen Sie auch die anderen Teile der Artikel-Serie:

Teil 2: ROI von Produktdatenqualität – Vorgehen im Projekt

Teil 3: ROI von Produktdatenqualität – Anwendung der dynamischen Investitionsrechnung